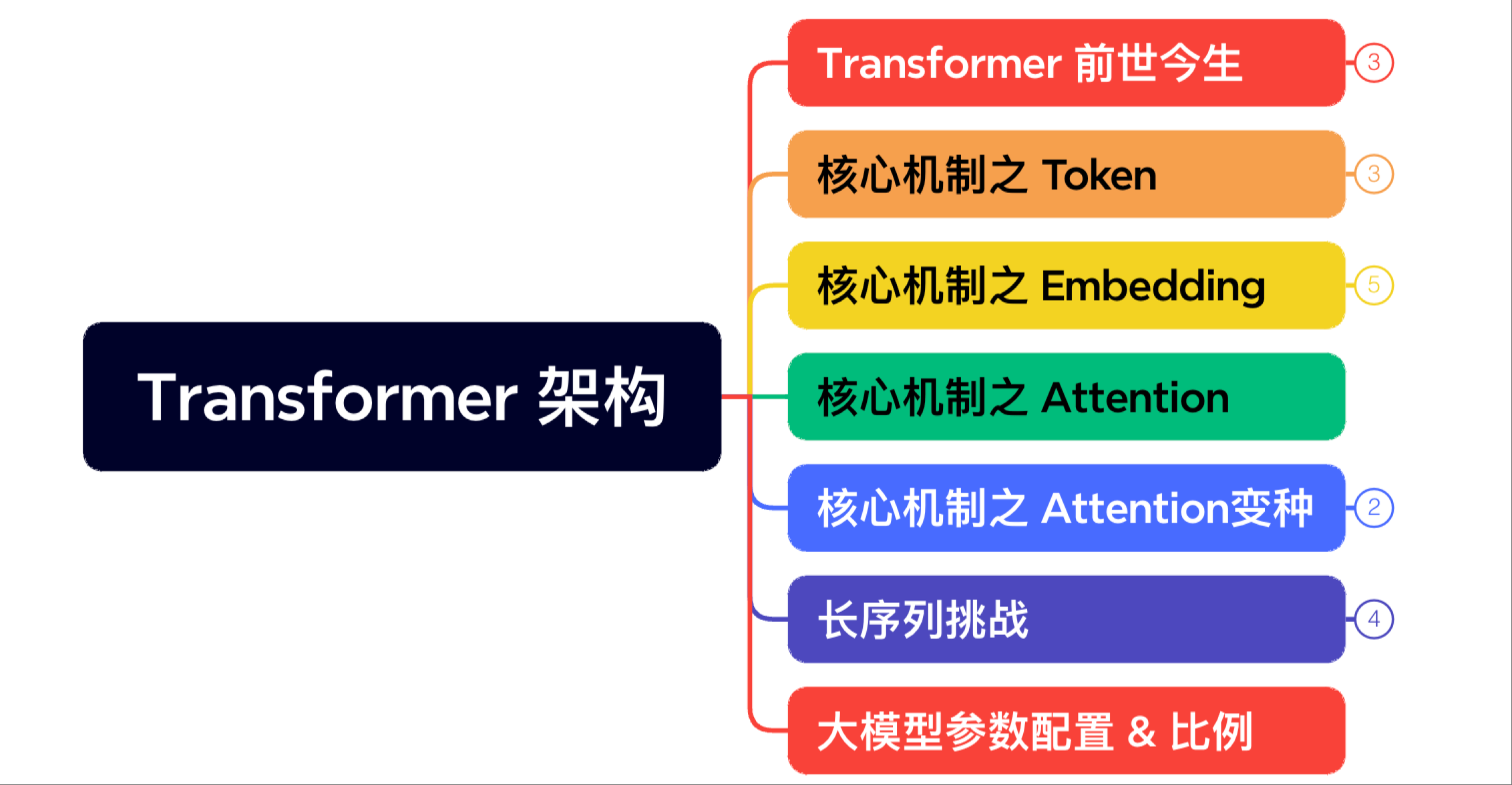

Transformer 架构#

本系列视频将系统性地讲解 Transformer 架构的核心原理及其在 LLM 中的关键技术实现。从 Transformer 的基础结构入手,逐步深入 Tokenizer 分词算法、Embedding 向量化技术、Attention 注意力机制及其多种变种算法,并专门探讨 Transformer 在长序列处理上的架构优化方案,最后详解大模型训练与推理中的关键参数设置。为深入理解与应用前沿 AI 技术奠定坚实基础。

内容大纲#

建议优先下载 PDF 版本,PPT 版本会因为字体缺失等原因导致版本很丑哦~

大纲 |

小节 |

链接 |

状态 |

|---|---|---|---|

Transformer 架构 |

01 Transformer 基础结构 |

:white_check_mark: |

|

Transformer 架构 |

02 大模型 Tokenizer 算法 |

:white_check_mark: |

|

Transformer 架构 |

03 大模型 Embedding 算法 |

:white_check_mark: |

|

Transformer 架构 |

04 Attention 注意力机制 |

:white_check_mark: |

|

Transformer 架构 |

05 Attention 变种算法 |

:white_check_mark: |

|

Transformer 架构 |

06 Transformer 长序列架构 |

:white_check_mark: |

|

Transformer 架构 |

07 大模型参数设置 |

:white_check_mark: |

|

:sparkling_heart: |

:star2: |

:sparkling_heart: |

|

代码实践 |

01 搭建迷你 Transformer |

:white_check_mark: |

|

代码实践 |

02 从零实现 Transformer 训练 |

:white_check_mark: |

|

代码实践 |

03 实战 Transformer 机器翻译 |

:white_check_mark: |

|

代码实践 |

04 手把手实现核心机制 Sinusoidal 编码 |

:white_check_mark: |

|

代码实践 |

05 手把手实现核心机制 BPE 分词算法 |

:white_check_mark: |

|

代码实践 |

06 手把手实现核心机制 Embedding 词嵌入 |

:white_check_mark: |

|

代码实践 |

07 深入注意力机制 MHA、MQA、GQA、MLA |

:white_check_mark: |

内容大纲#

备注#

文字课程内容正在一节节补充更新,每晚会抽空继续更新正在 AI Infra ,希望您多多鼓励和参与进来!!!

文字课程开源在 AI Infra,系列视频托管B 站和油管,PPT 开源在github,欢迎引用!

- 01.Transformer 结构介绍

- 02.大模型 Tokenizer 算法

- 03.大模型 Embedding 算法

- 04.Attention 注意力机制

- 05.Attention 变种算法

- 07.大模型参数设置

- CODE01: 搭建迷你 Transformer(DONE)

- CODE02: 从零实现 Transformer 训练(DONE)

- CODE03:Transformer 机器翻译(DONE)

- CODE04:实现 Sinusoidal 编码(DONE)

- CODE05:实现 BPE 分词(DONE)

- 手把手实现核心机制 Embedding 词嵌入(DONE)

- CODE07:深入注意力机制 MHA、MQA、GQA、MLA(DONE)